deepseek满血版其实就是官方提供的deepseek,deepseek满血版采用了DeepSeek-R1大模型云服务,而你会发现deepseek官方安装包的深度思考就是r1模型,由此证明deepseek满血版和deepseek是同一个软件,在使用过程中如果用户关闭深度思考的R1模型,软件则不具备满血版相关特性

deepseek官网:https://www.deepseek.com/

deepseek满血版是什么意思

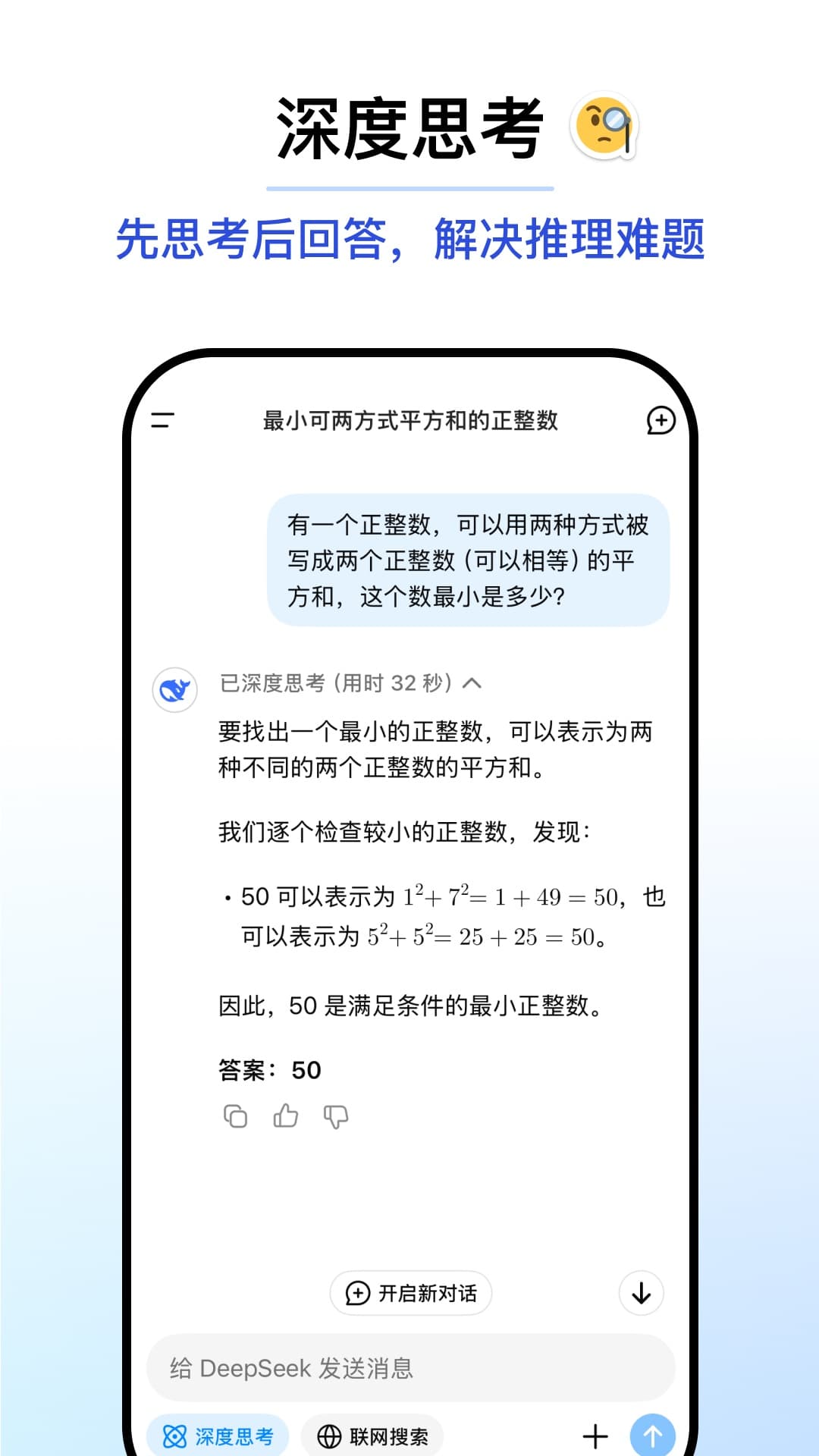

deepseek满血版指的就是deepseek-R1,在打开深度思考,接入R1模型后就是满血版了

注意:深度思考的R1模型用户可根据自身需求自由关闭或是开启

deepseek满血版和原版有什么区别

deepseek满血版的深度思考(R1)必须是开启的;

deepseek原版则可以自由开启或是关闭深度思考(R1);

deepseek满血版怎么用

这里以制作ppt为例

1、先登录软件

2、然后选择开始对话

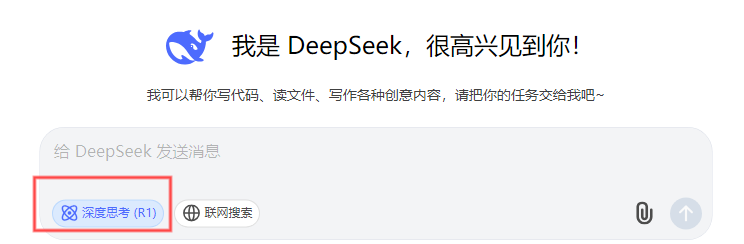

3、在对话页面中开启深度思考(R1)模型

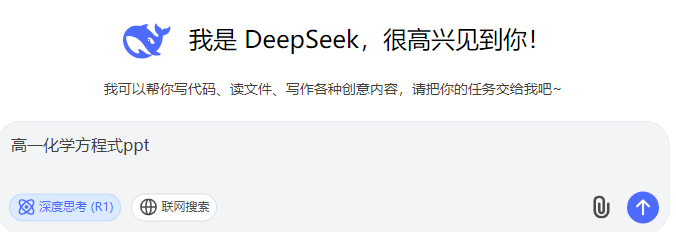

4、接着在输入框内输入ppt关键词,以及想达到的理想效果

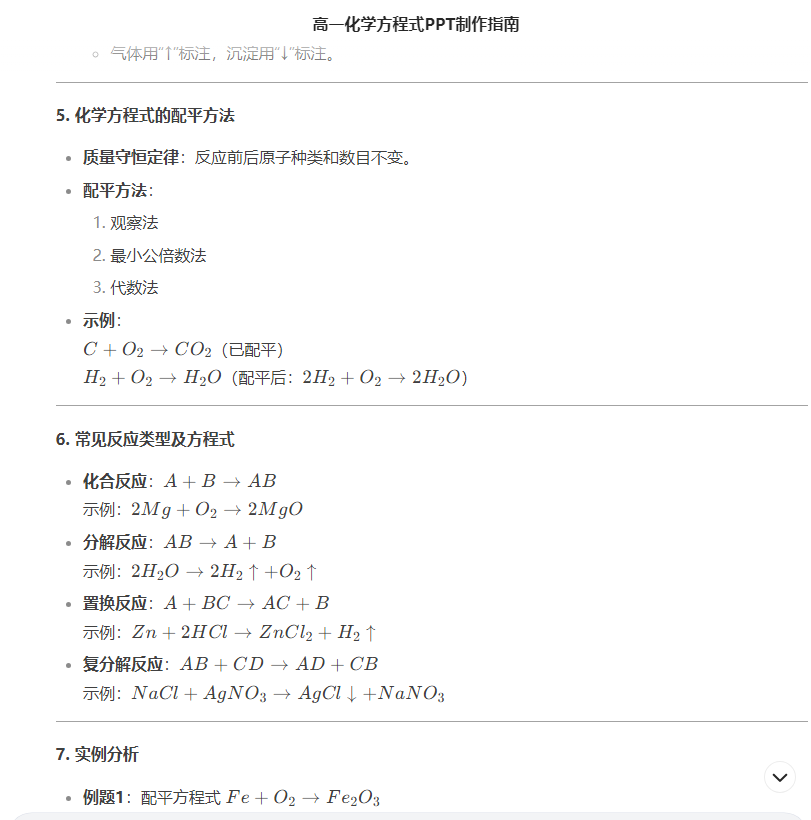

5、随后系统会生产完整的ppt大纲,用户将ppt大纲复制下来

6、再打开另外一个超好用的ai工具,kimi智能助手

7、选择ppt助手进入

8、将在deepseek满血版上生成的ppt大纲粘贴下来

9、最后点击一键生成ppt就可以啦

deepseek满血版本地部署硬件要求

一、基础版本(如7B/13B参数)

训练阶段

至少需要1块NVIDIA A100 40GB显卡,单卡训练时需开启梯度检查点优化。多卡训练推荐使用4块A100 80GB显卡,并使用ZeRO-3优化并行策略。显存需求方面,单卡需≥24GB(FP16精度),内存需求为≥64GB DDR4。存储需求为≥500GB NVMe SSD,用于高速数据加载。

推理阶段

可以使用RTX 3090/4090(24GB显存)或T4(16GB显存,需量化至INT8)。显存需求方面,7B模型需≥10GB(FP16),13B模型需≥16(INT4量化)

二、大型版本(如33B/70B参数)

训练阶段

必须使用多卡并行,推荐8块A100 80GB或H100,结合Tensor并行和流水线并行。显存需求方面,单卡需≥40GB(FP16 + ZeRO-3优化),内存需求为≥256GB DDR4 ECC。存储需求为≥1TB NVMe SSD,数据集较大时需扩容。

推理阶段

需要2块A100 40GB(33B模型)或4块A100 80GB(70B模型,FP16)。量化支持方面,70B模型INT4量化后可在2块RTX 4090(24GBx2)上运行。CPU备用方案需≥64核 + 256GB内存(仅适合批量处理)

DeepSeek满血版常见问题

1、DeepSeek满血版支持哪些操作系统

Linux、安卓、苹果

2、deepseek满血版671b是什么意思

DeepSeek满血版671b这一表述可能指的是深度求索(DeepSeek)公司推出的某个高性能AI模型或产品版本,模型通常以参数规模命名,例如DeepSeek-67B

deepseek满血版可以干什么

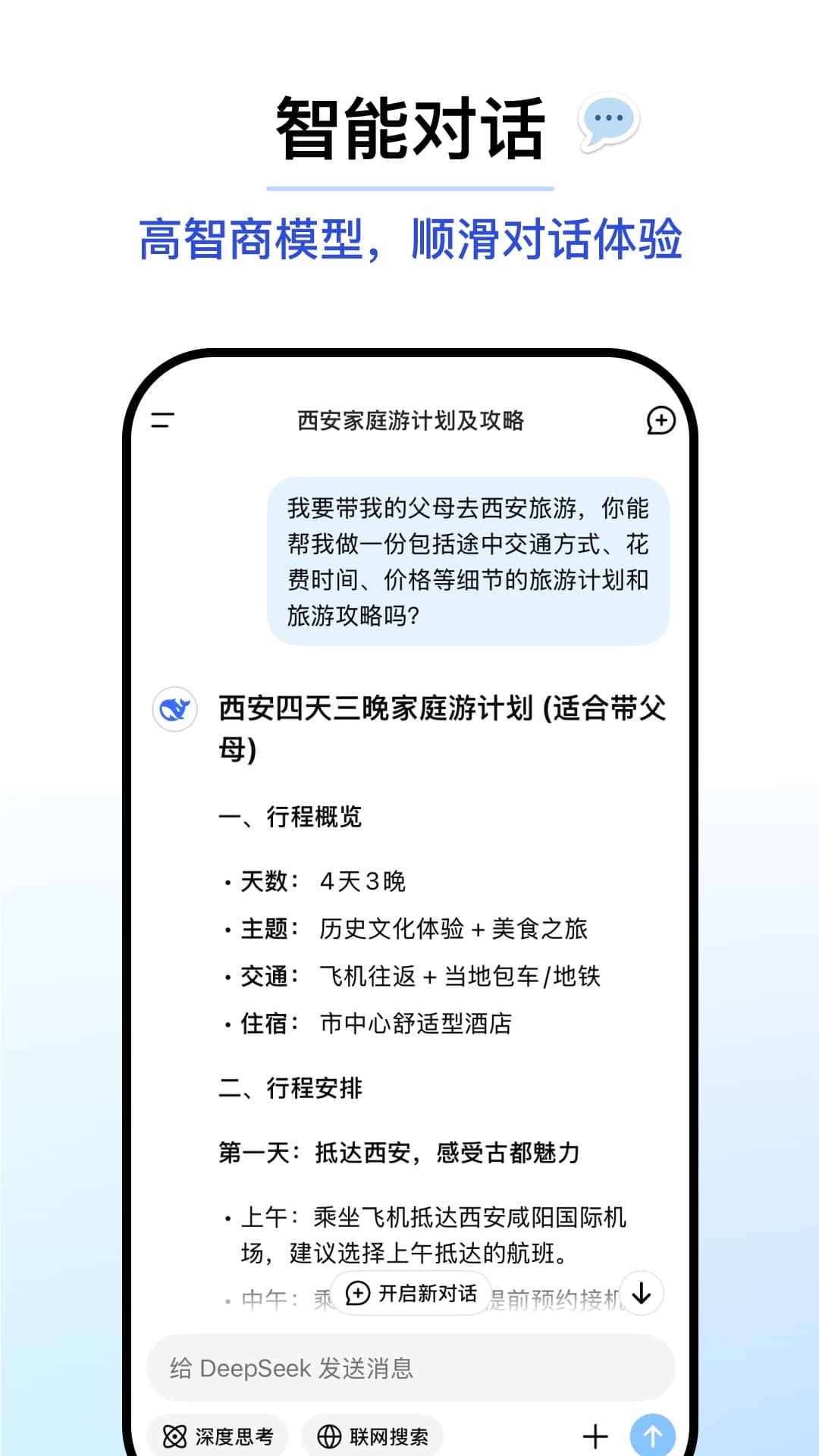

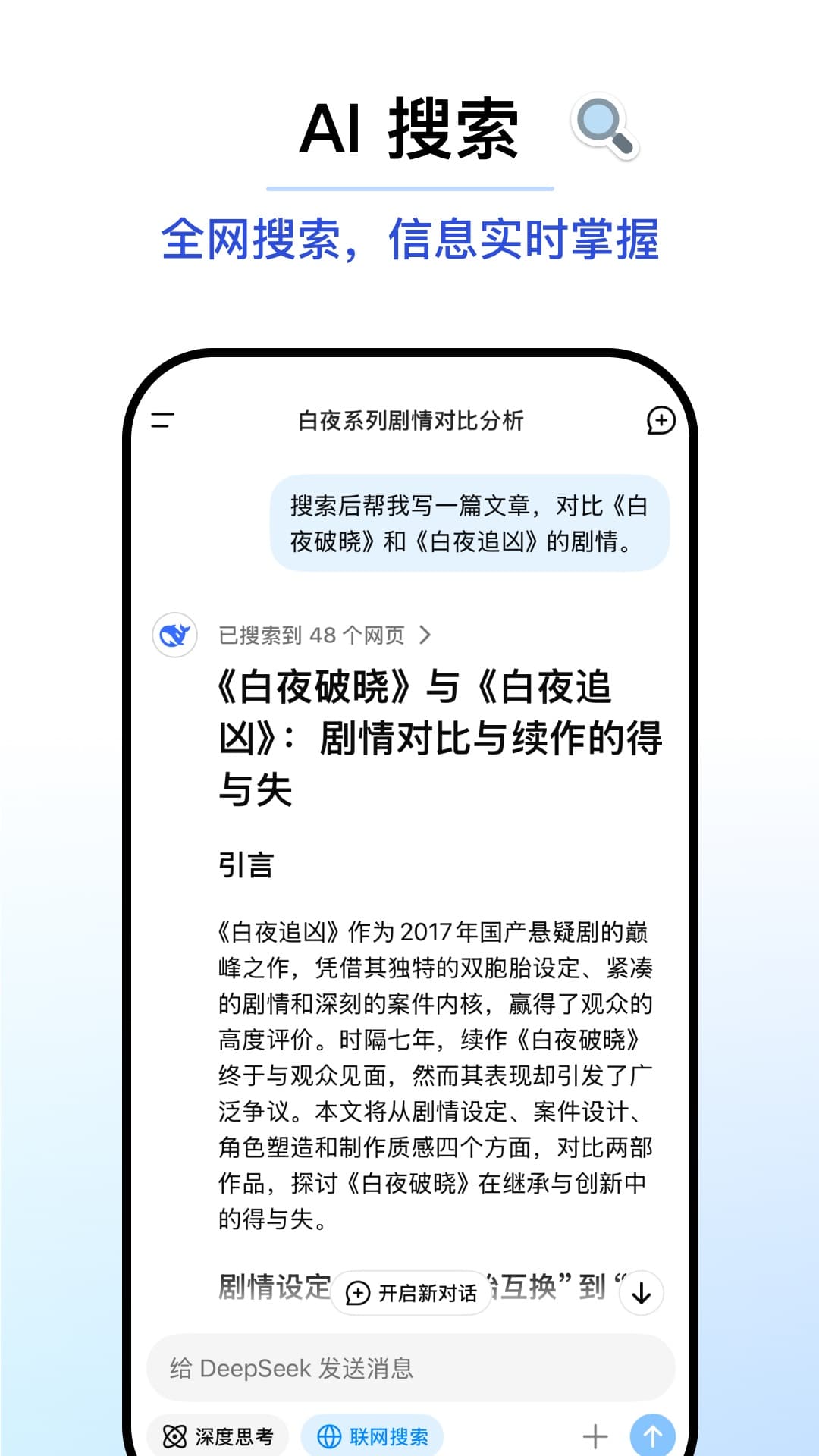

1、智能对话与问答:能够提供流畅、精准的中文对话体验,适用于日常聊天、知识问答、学术咨询等多种场景。

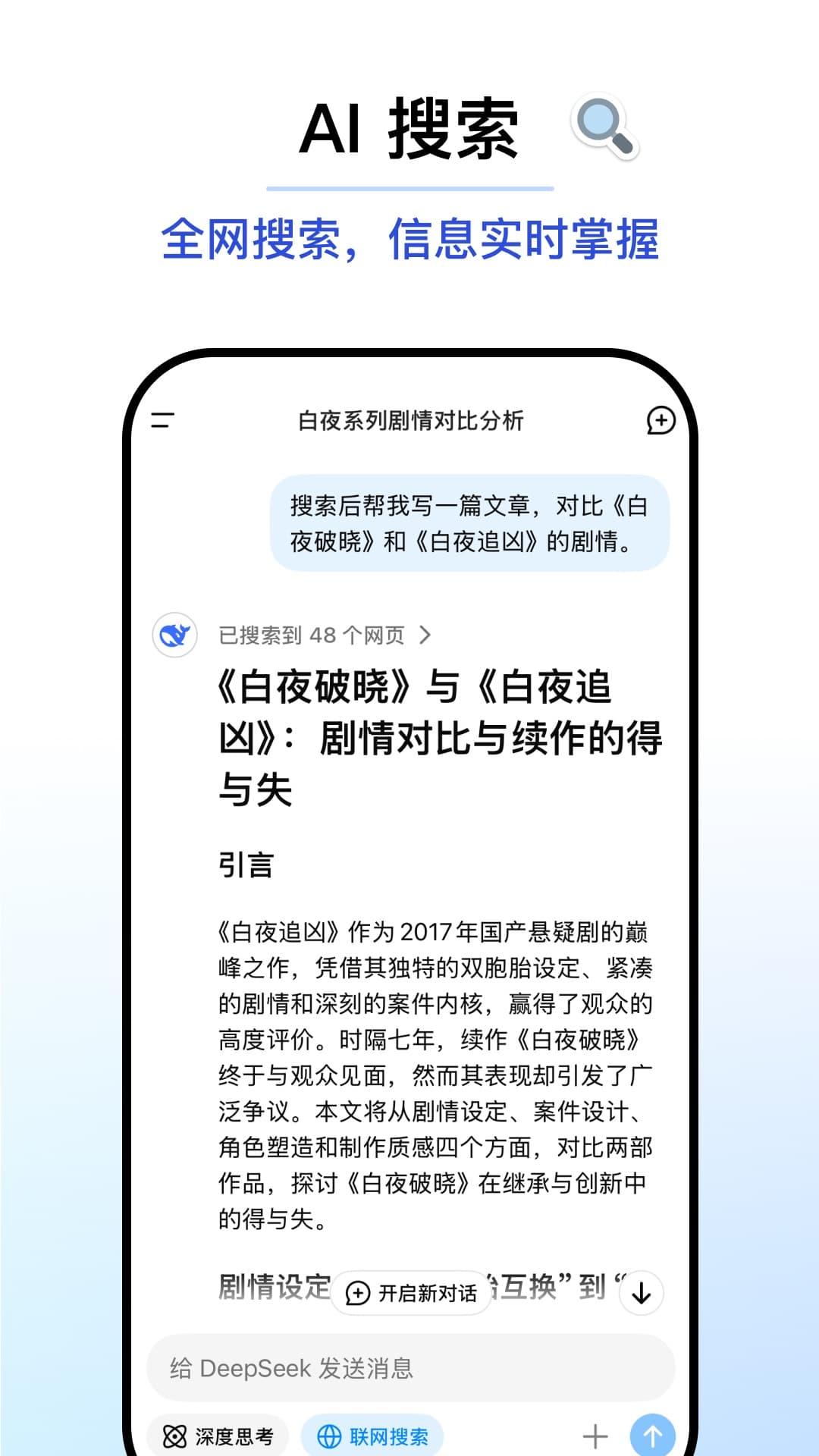

2、内容创作:可以用于写作、创意写作、翻译、生成PPT等多种内容创作任务,帮助用户快速生成高质量的文本。

3、教育与科研:在教育领域,DeepSeek满血版可以用于辅助教学、科研数据分析、论文写作等,提供强大的知识支持。

4、多模态应用:结合图像处理工具,DeepSeek满血版可以用于图像生成、视频生成等多模态任务。

5、编程辅助:在编程领域,DeepSeek满血版可以生成代码片段、优化代码逻辑、修复代码问题,支持多种编程语言。

- 发行商:杭州深度求索人工智能基础技术研究有限公司

- 更新日期:2025-04-09 17:54

- 应用大小:9.63MB

- 当前版本: v1.1.6

- 系统要求: 安卓系统5.2以上

- 包名:com.deepseek.chat

- MD5:BFB79528D99C4E8C75A9580344E8348B

- 隐私说明 : 点击查看

- 应用权限:查看详情

首页

首页